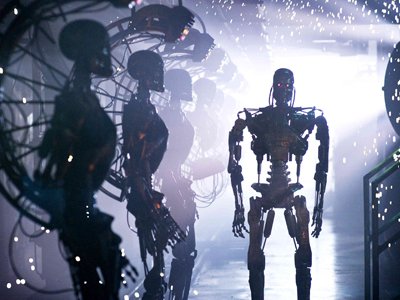

Технологии последних двух десятилетий сделали Терминатора возможным не только на экране. Мир лишь начинает осознавать, насколько глубоким будет влияние полностью автоматизированных систем на все аспекты жизни. Право одним из первых столкнется с новыми вызовами — законодательство, регулирующее войну, традиционно отстает от развития техники. "Право.Ru" попытался обозначить будущие юридические проблемы робототехники.

Одной из целей развития военных технологий всегда было удалить своих солдат от армии противника — копье, лук, пулемет, и т.д. ХХ век создал принципиально новый вид оружия — автоматизированные устройства, действующие там, где стреляют, но управляемые издалека. Военные роботы теперь наполняют сушу, воздух и море, и с каждой новой моделью они становятся все более смертоносными, автономными и даже интеллектуальными. "Роботы, которых вы видите сегодня, подобны 'модели Т' Форда. Мы наблюдаем лишь самые ранние этапы развития технологии", заметил высокопоставленный сотрудник одной из компаний, разрабатывающих роботов. Как известно, Генри Форд продал лишь 239 экземпляров своего сверхзнаменитого автомобиля в первый год — и 15 миллионов за последующие 19 лет. Спрос на роботизированные системы растет необыкновенно быстро.

До недавнего времени наземные системы обычно представляли собой традиционные устройства, лишь оснащенные дистанционным управлением, часто через оптоволоконный кабель, так что главным оружием против них были ножницы. Но все изменилось 11 сентября 2001 г. Военный бюджет США за 2002-2008 гг. вырос на 74% до $515 млрд — это не считая расходов на войны в Ираке и Афганистане, — и значительная доля этих денег пошла на исследования и разработки. В центре внимания оказались как раз системы, действующие по "безлюдной технологии", управляемые издалека.

В разрабатываемые сейчас модели закладывается возможность перейти к полностью автономному функционированию — а значит, автономному, без участия человека, принятию решений. Наземные роботы, вроде MARCBOT (Multi-Function Agile Remote-Controlled Robot) уже широко используются в Ираке. На подходе совершенно новые, например, "Gladiator" — "первый в мире многофункциональный боевой робот", совместная разработка ВМС США и Университета Карнеги-Меллона. Первая версия управляется удаленным оператором с помощью контроллера PlayStation, но программное обеспечение допускает обновления, вплоть до полной передачи управления процессору робота — физические компоненты полностью готовы к самостоятельному функционированию. И эта маленькая машинка стоимостью $400 000 оснащена пулеметом, противотанковыми ракетами и несмертельным оружием.

Станет ли ли мир с роботами опаснее

Все слышали о доктрине гарантированного ядерного взаимоуничтожения. Но идея, что военные технологии могут остановить войны, сама по себе не нова. Еще в 1621 г. английский поэт Джон Донн писал, что изобретение новых пушек ограничит жестокость и кровопролитность войны; в XIX веке Альфред Нобель считал, что изобретенный им динамит настолько разрушителен, что сделает войны невозможными. Теперь такие же надежды возлагаются на роботов.

Логика понятна. Например, обеспечиваемое роботами точное целеуказание снижает сопутствующий ущерб, в том числе гибель гражданского населения. "Безлюдные системы" снизят эмоциональный накал боя, что позволит операторам таких устройств принимать решения, не опасаясь за свою жизнь и не переживая из-за раненых товарищей, а значит, более обдуманно и осмотрительно. Робот может позволить себе "войти" в помещение и стрелять только в тех, кто первым открыл огонь — в отличие от солдата, который за доли секунды должен отличить врага от беззащитных гражданских.

Но есть и другая сторона проблемы. Да, удаленность позволит солдатам принимать решения спокойно, но, возможно, слишком спокойно. Смерть служит не только источником ярости, но и некоторым ограничителем — военный психолог Дейв Гроссман показал в книге "Об убийстве" (On Killing), что возникновение психологической удаленности от происходящего делает убийство более приемлемым, а неоправданную жестокость более вероятной. "По мере того как война становится все более безопасной и легкой, а солдаты оказываются все дальше от ужасов войны и видят врагов не как людей, а скорее как пятна на экране, опасность потерять психологический ограничитель, которым являются эти ужасы, становится все более реальной", считает Кит Шуртлефф, военный священник в армии США и инструктор по этике в "Институте поддержки солдат".

Опосредованность влияет на то, каким человек видит себя — все знают, что в виртуальных мирах люди принимают на себя роль своего двойника, порой способного на то, что их "оригинал" в реальной жизни никогда бы не сделал. Как писал военный историк Карл Киган, "безлюдные системы" радикально обезличивают войну, создавая не просто физическую, но и психологическую дистанцию, из-за чего слишком легко можно забыть, что с обеих сторон — живые существа.

Полностью автономные системы ставят свои особые этические и юридические вопросы. Автономного робота можно запрограммировать так, чтобы машина учитывала действующее международное законодательство о войне и требовала разрешения человека при обнаружении гражданских лиц в зоне поражения. Например: "Является ли цель танком противника? Да. Находится ли цель в зоне разрешенного огня? Да. Есть ли дружественные цели в зоне поражения? Нет. Есть ли гражданские лица в зоне поражения? Нет. Использование оружия разрешено, вмешательства человека не требуется. Огонь!"

Но в действительности все совсем не так просто. Даже если робот полностью свободен от ошибок в программном обеспечении и механических сбоев — что само по себе труднодостижимо, — совсем не легко найти ответ на вопрос, как безошибочно выделить врага среди всего и всех присутствующих. Что если враг использует живой щит? Или гражданское лицо планирует атаку, но еще ничего незаконного не сделало — законно ли стрелять? У людей нет однозначного ответа на эти и множество других подобных вопросов, и вряд ли стоит ожидать, что роботам будет легче.

В 2002 г. пилот F-16 во время полета над Афганистаном увидел внизу вспышки, и решил, что его обстреливают. Опасаясь за свою жизнь, он нанес удар, не дожидаясь разрешения командования, но оказалось, что это были учения дружественных канадских войск. Он был признан виновным в нарушении служебного долга. Но представьте, что на месте человека-пилота был бы автоматизированный аппарат. Как определить ответственного? Это инженеры, допустившие ошибку при программировании, или командир подразделения беспилотников, или офицер, отдавший приказ использовать этот беспилотник? А может быть, все они вместе? Именно поэтому военные юристы так обеспокоены возможностью исключить человека из процесса принятия боевых решений.

Со временем международное сообщество может решить, например, что использование вооруженных и полностью автономных роботов не поддается регулированию, и запретит их вообще, как к этому призывают многие международные группы, такие, как Campaign to Stop Killer Robots. Но сейчас действующее законодательство, как на международном, так и на национальном уровнях просто не имеет ответов на многие вопросы.

Кристоф Хейнс, профессор права из ЮАР, которому ООН поручила исследовать эту проблему, считает, что "фундаментальный вопрос — это разрешать ли полностью автоматизированное принятие решений о причинении смерти". Эксперты формулируют несколько основных проблем, связанных с использованием автономных боевых систем, и возможные пути их решения.

Во-первых, очень трудно гарантировать, что роботы без внешнего управления будут различать военные и гражданские цели, как того требуют законы войны. Поэтому многие предлагают в принципе запретить использование смертельного оружия в автономном режиме. Робот должен использовать его только по прямому приказу человека.

Во-вторых, возникает вопрос права на самозащиту. Право человека защищать свои жизнь и здоровье общепризнано, но как быть с роботами? Представители военного ведомства США высказывались в том духе, что беспилотные самолеты имеют право защищать себя, в том числе путем упреждающих ударов. Но это очень опасная дорога. Для начала, насколько эффективно машина может выделить тех, кто представляет для нее действительную угрозу? Такая постановка вопроса ведет ко множеству неразрешимых на сей день проблем, связанных с функционированием интеллектуальных устройств в обществе и выходящих далеко за пределы сугубо военных применений. Могут ли роботы иметь права? Если да, то какие, каков должен быть диапазон и глубина допустимых решений у робота, чтобы признать его достаточно интеллектуальным, чтобы иметь права? И так далее. Ведь если робот может самостоятельно решать, причинять ли повреждения или даже смерть человеку, то почему он не может принимать и иных решений, касающихся его самого и окружающего мира?

В-третьих, кто все же отвечает за действия такого робота? По всей видимости, те, кто его создал и запрограммировал, тем самым предопределив принимаемые роботом решения. Если ошибка программиста привела к гибели людей, именно он должен отвечать за нее, причем нести именно уголовную, а не только гражданскую ответственность. Если офицер использовал самостоятельно действующего боевого робота и оказывается, что отданный им приказ или программа, которую он разрешил использовать, привели к нарушению законов войны, именно офицер должен отвечать за совершенные роботом преступления. Даже если офицер не имел целью нарушить законы, но мог обоснованно предполагать, что такое может произойти — именно он должен отвечать. Иначе под угрозой окажется правовая система в целом.

Возможно, стоит запретить определенные виды роботов, например, сделанные без использования металла — их особенно трудно обнаружить, и поэтому они будут особенно привлекательны для террористов.

Так или иначе, очень важно, чтобы весь процесс разработки, производства, владения и использования военных роботов был максимально прозрачным с точки зрения ответственности. Это нужно не только для того, чтобы постфактум определить, кто виноват, — четкое распределение ответственности послужит некоторым ограничителем для будущего "непредусмотренного" использования.

Как пишет Питер Сингер, профессор Института Брукинга, в статье "Военные роботы и законы войны", "не только ученые, но и все заинтересованные в будущем люди, начиная с теологов — которые первыми начали формулировать законы войны еще в Средневековье, — и кончая группами, защищающими права человека и ограничения на использование вооружений должны озаботиться дискуссией, куда технологическая революция ведет наше оружие и наши законы. И эта дискуссия должна быть глобальной, потому что проблема робототехники не ограничивается какой-то одной страной — программы разработки военных роботов ведутся уже в 43 странах".

https://pravo.ru/review/view/94866/

Одной из целей развития военных технологий всегда было удалить своих солдат от армии противника — копье, лук, пулемет, и т.д. ХХ век создал принципиально новый вид оружия — автоматизированные устройства, действующие там, где стреляют, но управляемые издалека. Военные роботы теперь наполняют сушу, воздух и море, и с каждой новой моделью они становятся все более смертоносными, автономными и даже интеллектуальными. "Роботы, которых вы видите сегодня, подобны 'модели Т' Форда. Мы наблюдаем лишь самые ранние этапы развития технологии", заметил высокопоставленный сотрудник одной из компаний, разрабатывающих роботов. Как известно, Генри Форд продал лишь 239 экземпляров своего сверхзнаменитого автомобиля в первый год — и 15 миллионов за последующие 19 лет. Спрос на роботизированные системы растет необыкновенно быстро.

До недавнего времени наземные системы обычно представляли собой традиционные устройства, лишь оснащенные дистанционным управлением, часто через оптоволоконный кабель, так что главным оружием против них были ножницы. Но все изменилось 11 сентября 2001 г. Военный бюджет США за 2002-2008 гг. вырос на 74% до $515 млрд — это не считая расходов на войны в Ираке и Афганистане, — и значительная доля этих денег пошла на исследования и разработки. В центре внимания оказались как раз системы, действующие по "безлюдной технологии", управляемые издалека.

В разрабатываемые сейчас модели закладывается возможность перейти к полностью автономному функционированию — а значит, автономному, без участия человека, принятию решений. Наземные роботы, вроде MARCBOT (Multi-Function Agile Remote-Controlled Robot) уже широко используются в Ираке. На подходе совершенно новые, например, "Gladiator" — "первый в мире многофункциональный боевой робот", совместная разработка ВМС США и Университета Карнеги-Меллона. Первая версия управляется удаленным оператором с помощью контроллера PlayStation, но программное обеспечение допускает обновления, вплоть до полной передачи управления процессору робота — физические компоненты полностью готовы к самостоятельному функционированию. И эта маленькая машинка стоимостью $400 000 оснащена пулеметом, противотанковыми ракетами и несмертельным оружием.

Станет ли ли мир с роботами опаснее

Все слышали о доктрине гарантированного ядерного взаимоуничтожения. Но идея, что военные технологии могут остановить войны, сама по себе не нова. Еще в 1621 г. английский поэт Джон Донн писал, что изобретение новых пушек ограничит жестокость и кровопролитность войны; в XIX веке Альфред Нобель считал, что изобретенный им динамит настолько разрушителен, что сделает войны невозможными. Теперь такие же надежды возлагаются на роботов.

Логика понятна. Например, обеспечиваемое роботами точное целеуказание снижает сопутствующий ущерб, в том числе гибель гражданского населения. "Безлюдные системы" снизят эмоциональный накал боя, что позволит операторам таких устройств принимать решения, не опасаясь за свою жизнь и не переживая из-за раненых товарищей, а значит, более обдуманно и осмотрительно. Робот может позволить себе "войти" в помещение и стрелять только в тех, кто первым открыл огонь — в отличие от солдата, который за доли секунды должен отличить врага от беззащитных гражданских.

Но есть и другая сторона проблемы. Да, удаленность позволит солдатам принимать решения спокойно, но, возможно, слишком спокойно. Смерть служит не только источником ярости, но и некоторым ограничителем — военный психолог Дейв Гроссман показал в книге "Об убийстве" (On Killing), что возникновение психологической удаленности от происходящего делает убийство более приемлемым, а неоправданную жестокость более вероятной. "По мере того как война становится все более безопасной и легкой, а солдаты оказываются все дальше от ужасов войны и видят врагов не как людей, а скорее как пятна на экране, опасность потерять психологический ограничитель, которым являются эти ужасы, становится все более реальной", считает Кит Шуртлефф, военный священник в армии США и инструктор по этике в "Институте поддержки солдат".

Опосредованность влияет на то, каким человек видит себя — все знают, что в виртуальных мирах люди принимают на себя роль своего двойника, порой способного на то, что их "оригинал" в реальной жизни никогда бы не сделал. Как писал военный историк Карл Киган, "безлюдные системы" радикально обезличивают войну, создавая не просто физическую, но и психологическую дистанцию, из-за чего слишком легко можно забыть, что с обеих сторон — живые существа.

- Права машины

Полностью автономные системы ставят свои особые этические и юридические вопросы. Автономного робота можно запрограммировать так, чтобы машина учитывала действующее международное законодательство о войне и требовала разрешения человека при обнаружении гражданских лиц в зоне поражения. Например: "Является ли цель танком противника? Да. Находится ли цель в зоне разрешенного огня? Да. Есть ли дружественные цели в зоне поражения? Нет. Есть ли гражданские лица в зоне поражения? Нет. Использование оружия разрешено, вмешательства человека не требуется. Огонь!"

Но в действительности все совсем не так просто. Даже если робот полностью свободен от ошибок в программном обеспечении и механических сбоев — что само по себе труднодостижимо, — совсем не легко найти ответ на вопрос, как безошибочно выделить врага среди всего и всех присутствующих. Что если враг использует живой щит? Или гражданское лицо планирует атаку, но еще ничего незаконного не сделало — законно ли стрелять? У людей нет однозначного ответа на эти и множество других подобных вопросов, и вряд ли стоит ожидать, что роботам будет легче.

В 2002 г. пилот F-16 во время полета над Афганистаном увидел внизу вспышки, и решил, что его обстреливают. Опасаясь за свою жизнь, он нанес удар, не дожидаясь разрешения командования, но оказалось, что это были учения дружественных канадских войск. Он был признан виновным в нарушении служебного долга. Но представьте, что на месте человека-пилота был бы автоматизированный аппарат. Как определить ответственного? Это инженеры, допустившие ошибку при программировании, или командир подразделения беспилотников, или офицер, отдавший приказ использовать этот беспилотник? А может быть, все они вместе? Именно поэтому военные юристы так обеспокоены возможностью исключить человека из процесса принятия боевых решений.

Со временем международное сообщество может решить, например, что использование вооруженных и полностью автономных роботов не поддается регулированию, и запретит их вообще, как к этому призывают многие международные группы, такие, как Campaign to Stop Killer Robots. Но сейчас действующее законодательство, как на международном, так и на национальном уровнях просто не имеет ответов на многие вопросы.

Кристоф Хейнс, профессор права из ЮАР, которому ООН поручила исследовать эту проблему, считает, что "фундаментальный вопрос — это разрешать ли полностью автоматизированное принятие решений о причинении смерти". Эксперты формулируют несколько основных проблем, связанных с использованием автономных боевых систем, и возможные пути их решения.

Во-первых, очень трудно гарантировать, что роботы без внешнего управления будут различать военные и гражданские цели, как того требуют законы войны. Поэтому многие предлагают в принципе запретить использование смертельного оружия в автономном режиме. Робот должен использовать его только по прямому приказу человека.

Во-вторых, возникает вопрос права на самозащиту. Право человека защищать свои жизнь и здоровье общепризнано, но как быть с роботами? Представители военного ведомства США высказывались в том духе, что беспилотные самолеты имеют право защищать себя, в том числе путем упреждающих ударов. Но это очень опасная дорога. Для начала, насколько эффективно машина может выделить тех, кто представляет для нее действительную угрозу? Такая постановка вопроса ведет ко множеству неразрешимых на сей день проблем, связанных с функционированием интеллектуальных устройств в обществе и выходящих далеко за пределы сугубо военных применений. Могут ли роботы иметь права? Если да, то какие, каков должен быть диапазон и глубина допустимых решений у робота, чтобы признать его достаточно интеллектуальным, чтобы иметь права? И так далее. Ведь если робот может самостоятельно решать, причинять ли повреждения или даже смерть человеку, то почему он не может принимать и иных решений, касающихся его самого и окружающего мира?

В-третьих, кто все же отвечает за действия такого робота? По всей видимости, те, кто его создал и запрограммировал, тем самым предопределив принимаемые роботом решения. Если ошибка программиста привела к гибели людей, именно он должен отвечать за нее, причем нести именно уголовную, а не только гражданскую ответственность. Если офицер использовал самостоятельно действующего боевого робота и оказывается, что отданный им приказ или программа, которую он разрешил использовать, привели к нарушению законов войны, именно офицер должен отвечать за совершенные роботом преступления. Даже если офицер не имел целью нарушить законы, но мог обоснованно предполагать, что такое может произойти — именно он должен отвечать. Иначе под угрозой окажется правовая система в целом.

Возможно, стоит запретить определенные виды роботов, например, сделанные без использования металла — их особенно трудно обнаружить, и поэтому они будут особенно привлекательны для террористов.

Так или иначе, очень важно, чтобы весь процесс разработки, производства, владения и использования военных роботов был максимально прозрачным с точки зрения ответственности. Это нужно не только для того, чтобы постфактум определить, кто виноват, — четкое распределение ответственности послужит некоторым ограничителем для будущего "непредусмотренного" использования.

Как пишет Питер Сингер, профессор Института Брукинга, в статье "Военные роботы и законы войны", "не только ученые, но и все заинтересованные в будущем люди, начиная с теологов — которые первыми начали формулировать законы войны еще в Средневековье, — и кончая группами, защищающими права человека и ограничения на использование вооружений должны озаботиться дискуссией, куда технологическая революция ведет наше оружие и наши законы. И эта дискуссия должна быть глобальной, потому что проблема робототехники не ограничивается какой-то одной страной — программы разработки военных роботов ведутся уже в 43 странах".

https://pravo.ru/review/view/94866/

Комментариев нет:

Отправить комментарий